Overview

1.Large Language Model == Next Token Prediction 大语言模型就是单字接龙模型

2.LLM 怎么 train?

3.LLM 怎么 inference?

4.Emergent abilities 涌现能力

5.Why LLM work in Everywhere? 为啥 LLM 是真的能 work?

6.LLM: A Way to AGI LLM 是走向通用人工智能一条路径

Large Language Model == Next Token Prediction 大语言模型就是单字接龙模型

涉及到自然语言的任务, (几乎) 所有的任务都可以被转化成 Next Token Prediction 问题; 所以 2024.11.01 目前来看 LLM 其实就是在做 Next Token Prediction, 还是遵循的 GPT 原始的思想

比如 QA Task:

Where is Tsinghua hua University ? Answer:

=> Beijing

比如机器翻译

Machine Translation:

Tom chases Jerry

汤姆追杰瑞

仍然可以理解为 Next Sentence Prediction

Tom chases Jerry => 汤

Tom chases Jerry 汤 => 姆

Tom chases Jerry 汤姆 => 追

Tom chases Jerry 汤姆追 => 杰

Tom chases Jerry 汤姆追杰 => 瑞

LLM 怎么 train ?

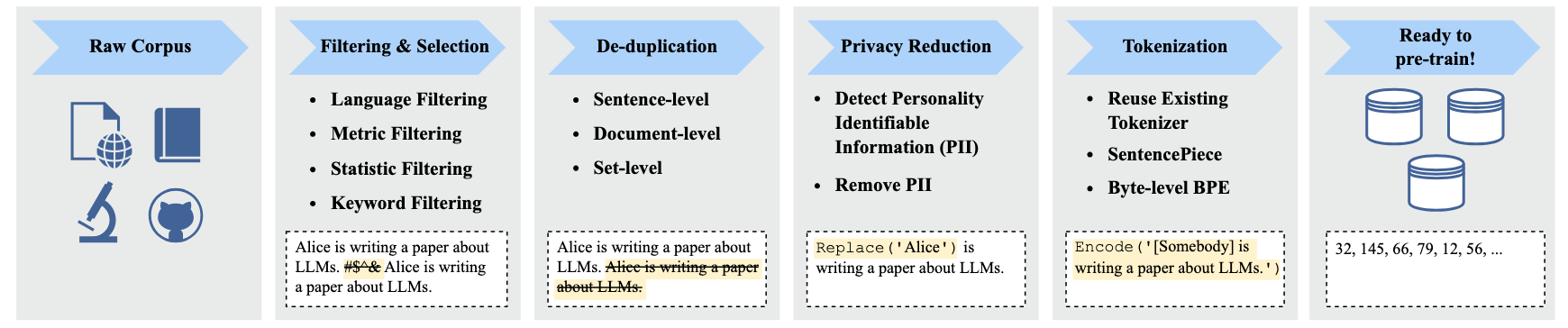

前置条件: 需要收集海量的高质量的数据, 并进行有效的预处理; 虽然我们谈到模型总会提到各种模型结构, 炼丹技巧, 或者推理性能等等, 但是最核心的还是原始高质量数据的获得

intuitively,

1.从互联网找到一切可用的高质量数据, 然后进行清洗工作, 具体来说就是 filtering & selection: 过滤掉各种噪声数据和 dirty word, 过滤的方法其实是启发式+模型的结合, 完全取决于对数据的一种理解; 接下来就是去重, 去重需要做到各种级别: sentence-level, doc-level 或者 url-level 等等; 去重之后就要进行隐私保护, 可以理解为一种特殊的过滤

2.语料质量搞干净之后, 就需要 token 化, 这里涉及到一些算法

3.在具体训练的时候还会遇到很多问题, 比如数据混合的比例和 scaling law 的实验测试

当上述数据 ready 之后, 就可投入训练了, 训练过程分为三个阶段

Self-Supervised Pre-Training

=> Supervised Fine-Tuning

=> Reinforcement Learning from Human Feedback

1.Self-Supervised Pre-Training (自监督预训练): 收集大量的互联网数据, 利用收集到的无标注数据 training, training 就是在训练样本上做逐个 token 预测, 然后计算 loss 和 gradients, 然后做 optimization

2.Supervised Fine-Tuning (SFT, 有监督微调):

如果只有第一个阶段无监督的训练, 模型会异想天开扯一堆乱七八糟的东西, 不能拿来为人类所用 (我们先假设我们的目标是为我们所用); 因此 SFT 直接有监督学习我们要的那些个答案; SFT 的过程是必须的, 目前最强的 GPT4 花了 8 个月时间去做 SFT; 需要大量的人工标注的数据, 其实在这给人类已经注入了人工先验; 但是只要涉及到人工的答案, 很多问题没有标准答案, 很多问题有很多种表达形式比如说

Q: When was Tsinghua University founded ?

模型预测: In 1911, Tsinghua University was founded in Beijing.

Label: Tsinghua University was founded in 1911.

3.Reinforcement Learning from Human Feedback (RLHF)

让模型学习某些 (人类) 偏好 preference, 给多个输出给个打分, 给定人类的偏好, 更好给到模型的灵活性

LLM 怎么 inference?

LLM Model 输出在所有 token 上的概率分布, 输出过程其实就从分布中采样

Emergent Abilities 涌现能力

当 LLM 的参数量超过某个特定的阈值, LLM 就能展现出新的能力, 这种新的能力在小模型完全不具备

emergent 这个词, 本质上不是大模型里面提出的, 来自于统计物理学和复杂系统领域: 一个一个的个体行为很简单, 但是个体组成的系统, 会呈现出来超越个体的更强的, 更复杂的能力. 自然界很多这种现象, 水分子会凝结成非常复杂的雪花的形状, 单个水分子行为非常简单, 但是整体形成了非常复杂的规则. 地球的大气和人类的大脑都是非常复杂的系统, 理论上也能学习到相关能力

涌现出来什么能力呢 ? 几个例子:

1.In-Context Learning: 仅仅给 LLM 几个示例 (sample), 作为一种上下文 (context), 就能类比似的计算出来

2.Instruction Following: 我们给 LLM 一个非常复杂的指令, 我们的输入可以非常长, 要求非常多, 逻辑都非常复杂, LLM 能按照你一堆复杂的指令给出来

3.Chain-of-Thought: LLM 不仅能输出结果, 还能输出原来任务分解成多个子任务或者中间结果, 一步一步的推理出来最终的结果

Why LLM work in Everywhere? 为啥 LLM 是真的能 work?

有两个假设

1.Everything can be tokenized.

2.Every token can be learned.

intuitively,

1.LLM 能 work 或者说能通用的一个前提假设是: 一切数据都可 token 化, 且这些 token 的表达都可以被学习

LLM: A Way to AGI LLM 是走向通用人工智能一条路径

我们从另一个技术发展的角度去思考, 如何走向一个通用的人工智能? 以终为始, 假设我们真要走向一个通用的人工智能, 具体点就是有个很强的通用的模型, 我们幻想下这个模型应该是一个什么的状态? 总接下来这个 [通用] 实现了三个 [统一]

1.Unified architecture for various domains. 统一架构, 现在 Transformer 架构一统天下

2.Unified model for various tasks. 真正的多任务处理

3.Unified model for various modalities. 真正的多模态

这么强大的模型, 放在几年前是不敢想象的, 但是 LLM 的兴起是符合上面的三个规律的, 因此让人感觉语言模型可能真的是一条走向 AGI 的路经, LLM 的严谨规律和上面的三个理念能有高度的契合, 令人充满想象空间

Reference

[1]. A Survey of Large Language Models.

[2]. Large Language Models: A Survey.

转载请注明来源 goldandrabbit.github.io