Overview

1.针对用户行为触发的推荐场景, 提出 Trigger-Induced Recommendation, 显示捕捉用户实时意图.

2.Deep Interest Highlight Network 结构设计.

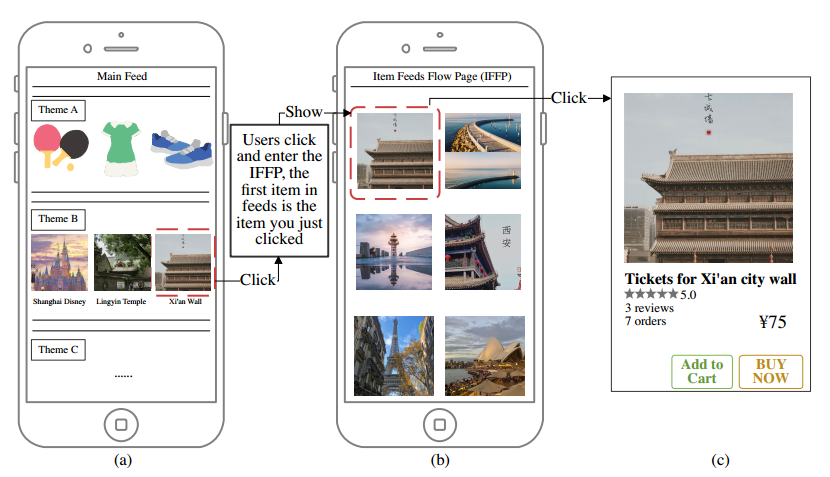

Theme-based recommendation in feeds

1.传统 session/sequence-based model 对于用户全行为序列一视同仁, 无法刻画用户实时意图, 即缺少对用户当前 trigger item 的意图建模; 设计用户意图网络模块, 显示捕捉用户实时意图.

2.信息流主题推荐场景中, 将 trigger 过程和 recommendation 过程分解: 用户在页面A点击一个商品 A1 (trigger item) 后, 会进入下一个商品推荐页 B, 该推荐页 B 展示多个同类或者相关商品.

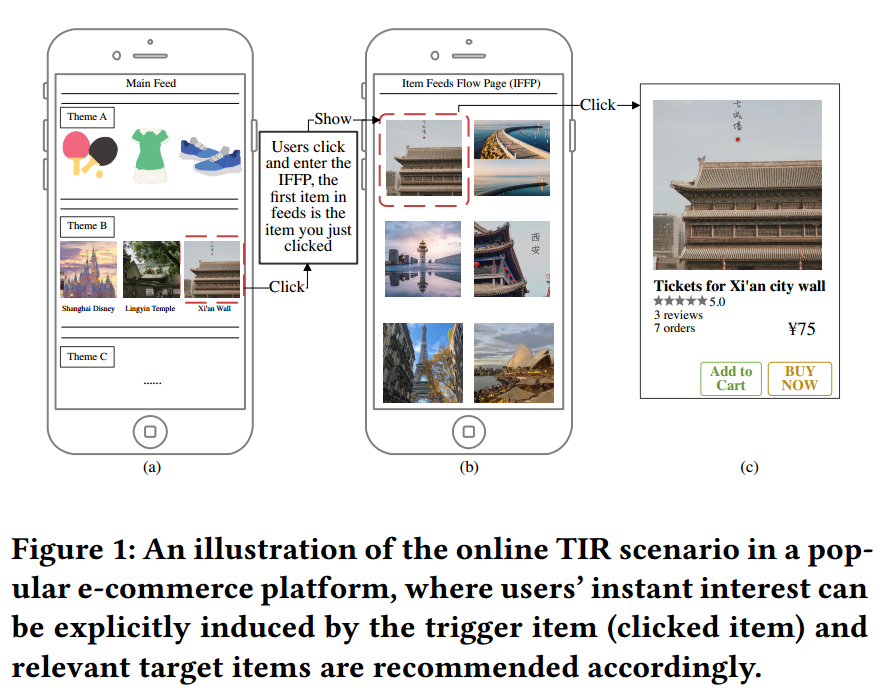

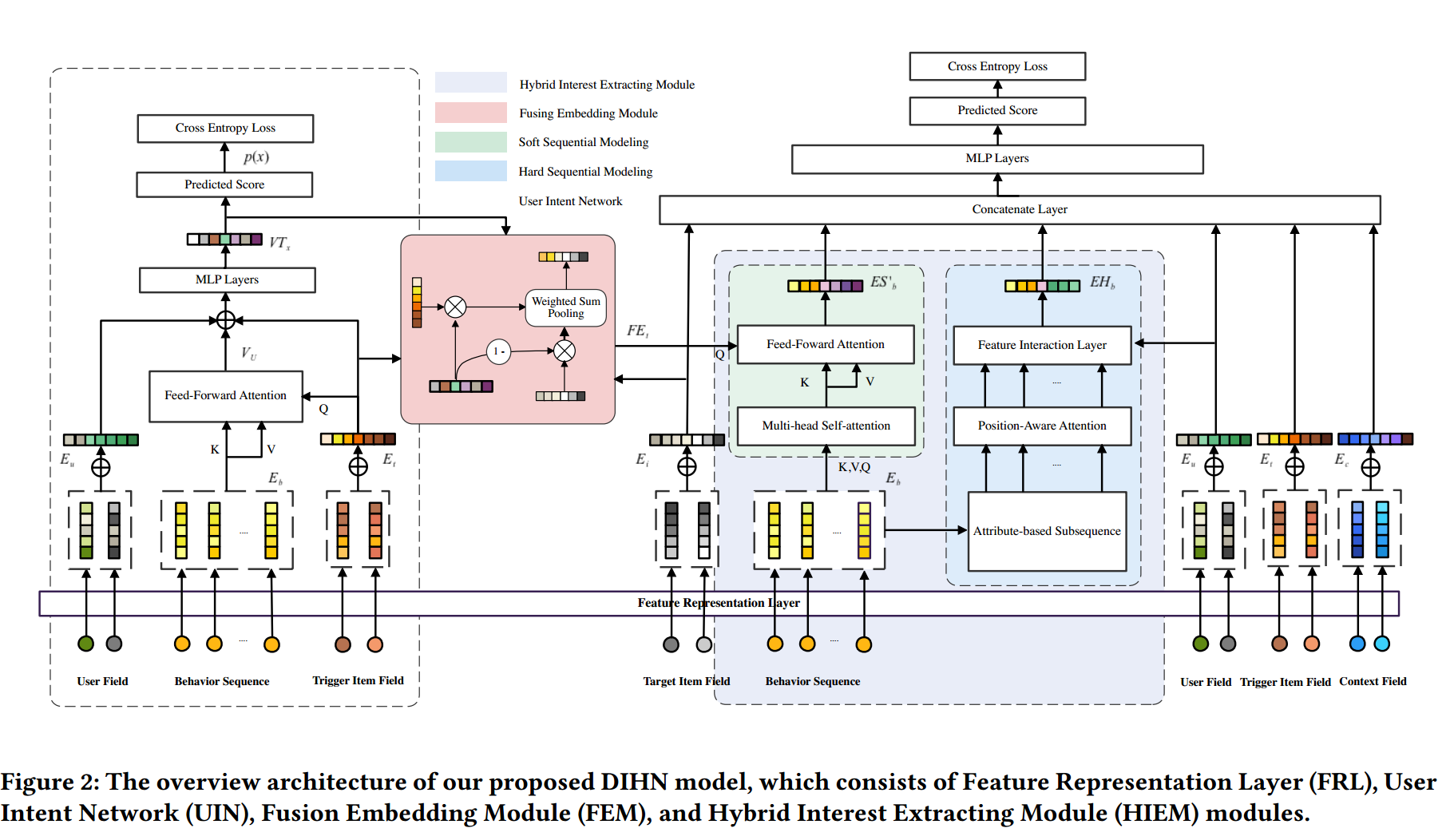

Deep Interest Highlight Network (DIHN)

引入用户意图网络模块, 显示捕捉用户实时意图, 网络设计包括三部分:

1.用户意图网络 (User Intent Network(UIN)): 对用户触发的商品给出精确打分, 预测用户兴趣

2.融合嵌入模块 (Fusion Embedding Module (FEM)): 将基于UIN产生的触发商品的 embedding, 和目标 embedding 融合

3.混合兴趣模块 (Hybrid Interest Extracting Module (HIEM)): 基于FEM的结果, 利用注意力机制挖掘用户即时兴趣.

Feature Representation Layer: 将 User Profile, User Behaviors, Trigger, Target Item, and Context 表示为 $𝐸u$, $𝐸𝑏$, $𝐸𝑡$, $𝐸𝑖$, $𝐸_𝑐$

User Intent Network: 通过用户当前触发的商品显式表达当前的兴趣. 如果用户错误触发商品会引入噪声, 如何评估当前商品是用户的兴趣, 通过UIN(User Itent Network)给用户当前触发的商品一个打分.

$V_u$ 是对 $E_t$ 的用户表示特征, $a(.)$ 是一个前馈网络, 输出是激活权重 $W_i$

将$V_u$, $E_u$, $E_t$ 拼接成 $x=[V_u;E_u;E]$, 通过MLP得到高维特征交叉 $VT_x$, 然后通过激活函数, 得到打分. 目标函数如下:

$N$ 个训练样本, $y={0, 1}$ 表示用户是否点击该trigger商品. 如果用户点击了该 trigger, 则包含该 trigger 的推荐页 B 中所有商品都有附加 label (eg: positive). 用于 UIN 有监督学习.

Fusion Embedding Module: 将 UIN 产生的 trigger 商品的 embedding 和 target 商品的 embedding 融合. 如何融合? 举 2 个极端 case: 如果用户对 trigger 商品无任何兴趣, 则 FEM 应该降级为是 target 商品的 embedding; 如果用户对 trigger 商品有极大兴趣, 则 FEM 应该降级为 trigger 商品的 embedding. 则对这些结果做融合.

Hybrid Interest Extracting Module: 在 TIR 场景下, 如何从用户历史行为明确获取用户 trigger 商品和目标商品的兴趣? 如果用户 trigger 商品, 则和该商品有相同属性(比如: 类目, 目标)的商品优先被作为子行为序列. 由于用户的兴趣会随着时间改变, 我们将位置编码作为 Q 通过 Attention 学习权重.

Loss function

整个模型的 Loss 分为两个部分

其中 $Loss_t$ 是 UIN 的 loss, $Loss_i$ 是经过 HIEM 的 Loss

Reference

[1]. Deep Interest Highlight Network for Click-Through Rate Prediction in Trigger-Induced Recommendation (WWW’22).

转载请注明来源 goldandrabbit.github.io